Virtualizzazione, la frontiera per l’ottimizzazione delle risorse nel settore ICT

L’attuale congiuntura economica mondiale sta portando le aziende a ricercare la massima efficienza nell’ottica del contenimento dei costi.

L’Informatica, grazie alla sua trasversalità in molteplici settori, può essere concretamente di aiuto in questo scenario, grazie alla virtualizzazione.

La virtualizzazione è una tecnologia collaudata che è stata utilizzata con successo sin dagli anni ’60, per partizionare l’hardware degli elaboratori di grandi dimensioni, denominati mainframe.

Data l’elevata capacità di elaborazione di tali macchine ed i loro costi elevatissimi, venne progettata la suddivisione logica in più macchine virtuali di dimensioni ridotte, in grado di avere prestazioni adeguate ai compiti loro assegnati, rendendo così possibile eseguire più progetti contemporaneamente su un singolo mainframe.

Vantaggi del contenimento dei server fisici

Analogamente a quanto accade con le automobili che spesso trasportano solo il guidatore senza alcun passeggero, risultando per questo “scariche”, così pure nel mondo dell’informatica si osserva che la notevole potenza di calcolo disponibile nei moderni server, spesso risulta essere decisamente sotto utilizzata: mediamente non oltre il 10-15% della capacità di calcolo.

Se è vero che è difficile mettere d’accordo tre o quattro persone per viaggiare sulla medesima vettura, fortunatamente nell’informatica l’ottimizzazione è agevole. Questo fatto consente pertanto di ottimizzare le risorse e distribuirle in modo più efficace, al fine di eseguire più carichi di lavoro su un numero ridotto di server.

Ecco alcuni dei principali vantaggi:

-

riduzione degli investimenti futuri in quanto per avere nuovi server basta generarli via software, finché esiste potenza residua di calcolo da parte dei server fisici: mediamente ogni server fisico è in grado di fornire potenza di calcolo sufficiente per 10-15 server virtuali

-

contenimento del costo complessivo di gestione in quanto minor hardware implica minori guasti e minor tempo dedicato alla manutenzione fisica

-

diminuzione dei costi relativi alla gestione della server farm, in quanto il numero dei server fisici risulta sensibilmente ridotto e conseguentemente i consumi energetici legati sia alla loro alimentazione che a quella dei sistemi di raffreddamento dei locali ove essi risiedono

-

aumento della flessibilità nella gestione poiché si possono velocemente modificare il numero di server virtuali, la loro configurazione, la loro topologia di collegamento

Questi vantaggi tecnologici, che peraltro non sono gli unici, si traducono nella reale e concreta possibilità di creare nuovi server virtuali in pochi minuti, ogni qual volta se ne sente il bisogno, senza dover ricorrere a investimenti hardware di alcun tipo.

E’ da sottolineare che la piattaforma di virtualizzazione è in grado di consentire la creazione di server virtuali su cui far funzionare applicativi e sistemi operativi datati (quali ad esempio Windows 3.1, 95, 98, ME, NT, 2000, etc) in modo da consentire il loro uso sui nuovi ambienti, peraltro con prestazioni sensibilmente superiori. In questo modo non si avrà più nessun vincolo rigido che lega i vecchi applicativi al vecchio hardware, perché l’hardware, ora, sarà solo virtuale.

Questo fattore è di strategica importanza nel mondo dell’informatica per via del rapidissimo processo di invecchiamento a cui sono soggetti i calcolatori elettronici.

Architetture tipiche per progettare sistemi di virtualizzazione

La progettazione di una ristrutturazione da una soluzione tradizionale ad una architettura informatica basata sulla virtualizzazione deve tenere conto di numerosi fattori, tra i quali:

-

il carico computazionale attuale, misurabile su ciascun singolo server

-

le caratteristiche tecniche delle macchine attualmente in esercizio

-

le stime di espansione dei sistemi di calcolo

-

le migliorie che si possono introdurre con la razionalizzazione delle topologie delle reti LAN esistenti, spesso non ottimali

Da questi dati di partenza si progetta l’architettura più adeguata ed il suo dimensionamento. Mentre quest’ultimo è direttamente proporzionale al carico computazionale, l’architettura invece è funzionale a numerosi fattori, legati anche ai livelli di prestazioni e di affidabilità che si desidera ottenere.

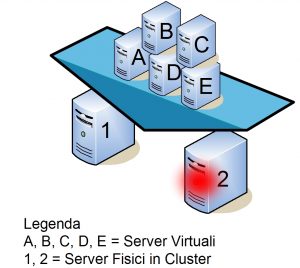

Una classica soluzione prevede l’utilizzo di cluster computazionali composti da almeno due server fisici, sui quali viene realizzato il sistema di virtualizzazione che ospiterà i diversi server virtuali.

L’utilizzo del cluster permette di realizzare un’architettura ad Alta Affidabilità, ossia caratterizzata dalla capacità di sopportare il completo cedimento di uno dei due server fisici senza compromettere il funzionamento dei sistemi virtuali presenti.

Per completare l’architettura, occorre prevedere un sistema di memorizzazione, sia per i dati che verranno utilizzati e generati da ciascun server virtuale, sia per i medesimi server che, ricordiamolo, essendo virtuali sono pertanto software, ossia file. L’ottimale funzionamento è realizzabile attraverso l’adozione di una SAN, Storage Area Network. Si tratta di un sistema dedicato alla memorizzazione dei dati su batterie di dischi rigidi in grado di garantire prestazioni elevate e livelli di affidabilità adeguata.

E’ possibile raggiungere l’Alta Affidabilità anche per sistema di memorizzazione, attraverso l’utilizzo di tecnologie RAID (Redundant Array of Independent Disks) e la ridondanza di diversi moduli hardware presenti in vari punti dell’architettura.